Na virada do século 20, um cavalo alemão conquistou a Europa. Hans, O esperto (Clever Hans), como era conhecido, parecia poder realizar todos os tipos de truques até então limitados aos humanos. Ele podia somar e subtrair números, dizer as horas e ler um calendário, até mesmo soletrar palavras e frases — tudo marcando a resposta com seu casco. “A” era um toque; “B” era dois; 2 + 3 era cinco. Ele foi uma sensação internacional — e prova viva, muitos acreditavam, de que os animais podiam ser ensinados a raciocinar tão bem quanto os humanos.

O problema era que Hans não estava realmente fazendo nenhuma dessas coisas. Como os investigadores descobriram mais tarde, o cavalo aprendeu a dar a resposta certa ao observar as mudanças na postura, respiração e expressões faciais de seus interrogadores. Se eles ficassem muito longe, Hans perderia suas habilidades. Sua inteligência era apenas uma ilusão.

Esta história é usada como um conto de advertência para pesquisadores de IA ao avaliar as capacidades de seus algoritmos. Um sistema nem sempre é tão inteligente quanto parece. Tome cuidado para avaliá-lo corretamente.

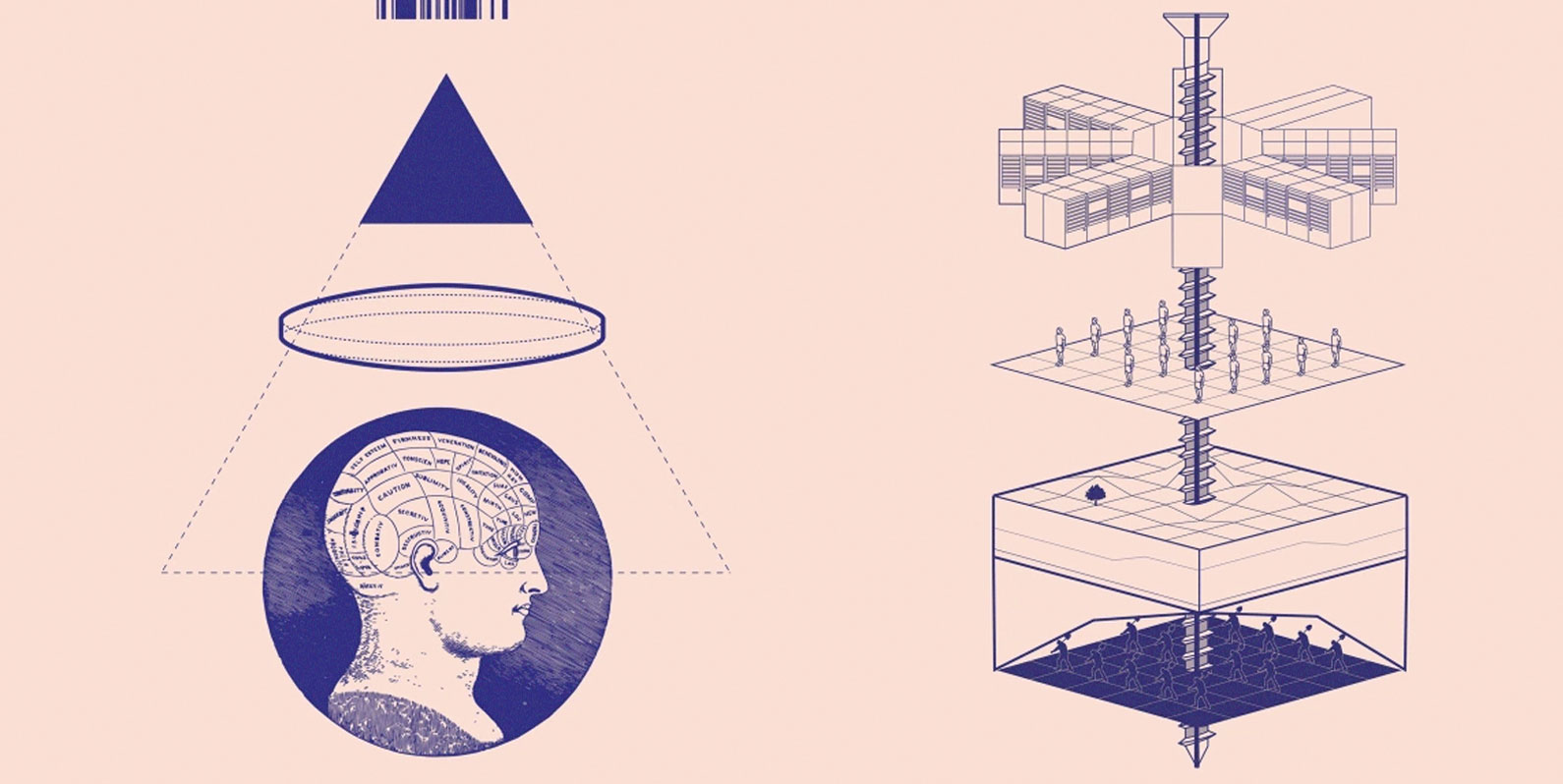

Mas em seu novo livro, Atlas of AI, a especialista líder em Inteligência Artificial (IA), Kate Crawford, vira essa lição de cabeça para baixo. O problema, ela escreve, estava na maneira como as pessoas definiam os feitos de Hans: “Hans já estava realizando proezas notáveis de comunicação interespécies, desempenho público e paciência considerável, mas não eram reconhecidos como inteligência”.

Assim começa a exploração de Crawford na história da Inteligência Artificial e seu impacto em nosso mundo físico. Cada capítulo busca ampliar nossa compreensão da tecnologia revelando o quão estreitamente a vemos e definimos.

Crawford faz isso nos levando em uma jornada global, das minas onde os elementos raros usados na fabricação de computadores são extraídos para os centros de abastecimento da Amazon, onde corpos humanos foram mecanizados na busca incessante da empresa por crescimento e lucro. No capítulo um, ela relata a condução de uma van que saiu do coração do Vale do Silício até uma pequena comunidade de mineração no Vale Clayton de Nevada. Lá, ela investiga as práticas ambientais destrutivas necessárias para obter o lítio que alimenta os computadores do mundo. É uma ilustração convincente de como esses dois lugares estão próximos no espaço físico, mas muito distantes em termos de riqueza.

Ao basear sua análise em tais investigações físicas, Crawford descarta o enquadramento eufemístico de que a IA é simplesmente um software eficiente executado na “nuvem”. Suas descrições vívidas e diretas da Terra e dos trabalhos sobre os quais as IAs são construídas, e as histórias profundamente problemáticas por trás disso, tornam impossível continuar falando sobre a tecnologia puramente no âmbito abstrato.

No capítulo quatro, por exemplo, Crawford nos leva a outra viagem — dessa vez no tempo, e não no espaço. Para explicar a história da obsessão desse campo da tecnologia com classificações, ela visita o Museu Penn na Filadélfia, onde ela observa filas e filas de crânios humanos.

Os crânios foram coletados por Samuel Morton, um craniologista americano do século 19, que acreditava ser possível dividi-los “objetivamente” por suas medidas físicas nas cinco “raças” do mundo: africano, nativo americano, caucasiano, malaio e mongol. Crawford traça paralelos entre o trabalho de Morton e os modernos sistemas de IA que continuam a classificar o mundo em categorias fixas.

Essas classificações estão longe de ser objetivas, ela argumenta. Eles impõem uma ordem social, naturalizam hierarquias e aumentam as desigualdades. Vista por essa lente, a IA não pode mais ser considerada uma tecnologia objetiva ou neutra.

Em seus 20 anos de carreira, Crawford lutou com as consequências no mundo real de sistemas de dados em grande escala, machine learning e IA. Em 2017, com Meredith Whittaker, ela foi cofundadora do instituto de pesquisa AI Now como uma das primeiras organizações dedicadas a estudar as implicações sociais dessas tecnologias. Ela também é agora professora da USC Annenberg, em Los Angeles, e a primeira presidente visitante em IA e justiça na École Normale Supérieure em Paris, bem como pesquisadora principal sênior da Microsoft Research.

Cinco anos atrás, Crawford diz, ela ainda estava trabalhando para introduzir a mera ideia de que dados e IA não eram neutros. Agora a conversa evoluiu e a ética da IA floresceu como um campo próprio. Ela espera que seu livro o ajude a amadurecer ainda mais.

Entrevistei Crawford para falar sobre seu livro. A seguir, alguns trechos dessa conversa.

Por que decidiu escrever este livro e o que ele significa para você?

Crawford: Muitos dos livros que foram escritos sobre inteligência artificial, na verdade, falam sobre realizações técnicas muito limitadas. E, às vezes, focam em grandes homens da IA, mas isso é tudo o que tivemos de informação para lidar com o que é inteligência artificial.

Acho que produziu esse entendimento muito distorcido da inteligência artificial como sistemas puramente técnicos que são de alguma forma objetivos e neutros e — como Stuart Russell e Peter Norvig dizem em seu livro — que atuam como agentes inteligentes que tomam a melhor decisão de qualquer ação possível.

Eu queria fazer algo muito diferente: entender realmente como a inteligência artificial é feita no sentido mais amplo. Isso significa olhar para os recursos naturais que a impulsionam, a energia que ela consome, o trabalho oculto em toda a cadeia de abastecimento e as grandes quantidades de dados que são extraídos de cada plataforma e dispositivos que usamos todos os dias.

Ao fazer isso, eu queria realmente abrir as portas de uma nova compreensão da IA como nem artificial nem inteligente. É o oposto de artificial. Vem das partes mais materiais da crosta terrestre e do trabalho de corpos humanos, e de tudo o que produzimos, falamos e fotografamos todos os dias. Nem é inteligente. Acho que há um grande pecado original neste campo, onde as pessoas presumiram que os computadores eram de alguma forma como cérebros humanos e se os treinássemos como se fossem crianças, aos poucos eles se tornariam esses seres sobrenaturais.

Isso é algo que acho realmente problemático — que compramos essa ideia de inteligência quando, na verdade, estamos apenas olhando para formas de análise estatística em escala que têm tantos problemas quanto os dados que são fornecidos.

Ficou imediatamente óbvio para você que é assim que as pessoas deveriam pensar sobre IA? Ou foi um processo?

Foi absolutamente um processo. Eu diria que um dos momentos decisivos para mim foi em 2016, quando comecei um projeto chamado “Anatomia de um sistema de IA” com Vladan Joler. Nós nos encontramos em uma conferência voltada especificamente para IA habilitada por voz e estávamos tentando mapear o que era necessário para fazer um Amazon Echo funcionar. Quais foram os componentes? Como você extrai os dados? Quais foram as camadas na distribuição de dados?

Percebemos que, na verdade, para entender isso, é preciso saber de onde vêm os componentes. Onde os chips foram produzidos? Onde estão as minas? Onde eles se fundem? Quais foram as rotas logísticas e cadeias de abastecimento?

Por fim, como rastrear o fim da vida útil desses dispositivos? Como você sabe onde está o lixo eletrônico em lugares como Malásia, Gana e Paquistão? Foi um projeto de pesquisa de dois anos que nos levou muito tempo para rastrear essas cadeias de suprimentos de materiais do início ao fim.

Quando você começa a analisar sistemas de IA em grande escala, e em um horizonte de tempo mais longo, afasta-se dos conceitos limitados de “IA justa” e “ética” para concluir que esses sistemas produzem mudanças geomórficas profundas e duradouras em nosso planeta, além de aumentar as formas de desigualdade de trabalho que já temos.

Isso me fez perceber que, ao invés de analisar um único dispositivo, o Amazon Echo, precisava aplicar esse tipo de analítica a toda a indústria. Isso para mim foi a grande tarefa, e é por isso que Atlas of AI levou cinco anos para ser escrito. Há uma grande necessidade de saber o que esses sistemas nos custam de verdade, porque raras são as vezes nas quais fazemos o trabalho de realmente compreender suas verdadeiras implicações planetárias.

A outra coisa que eu diria que tem sido uma verdadeira inspiração é o crescente campo de pesquisadores que estão fazendo essas importantes perguntas sobre trabalho, dados e desigualdade. Estou pensando em Ruha Benjamin, Safiya Noble, Mar Hicks, Julie Cohen, Meredith Broussard, Simone Brown — a lista continua. Vejo isso como uma contribuição para esse conjunto de conhecimento, trazendo perspectivas que conectam meio ambiente, direitos trabalhistas e proteção de dados.

Você viaja muito ao longo do livro. Quase todos os capítulos começam com uma boa olhada ao seu redor. Por que isso foi importante?

Foi uma escolha muito consciente basear uma análise de IA em locais específicos, para se afastar desses “nichos” abstratos do espaço algorítmico, onde muitos dos debates em torno do machine learning acontecem. E espero que isso destaque o fato de que quando não fazemos isso, quando apenas falamos sobre esses “espaços abstratos” de objetividade algorítmica, isso também é uma escolha política e tem ramificações.

No que tange o encadeamento dos locais juntos, pensei nisso justamente como uma metáfora de um atlas. Eles são livros incomuns que podem ser abertos e a escala de um continente inteiro pode ser vista, ou podem ser ampliados para observar uma cadeia de montanhas ou uma cidade. Assim, eles oferecem essas mudanças de perspectiva e escala.

Há uma frase adorável que uso no livro, utilizada pela física Ursula Franklin. Ela escreve sobre como os mapas unem o conhecido e o desconhecido em métodos de percepção coletiva. Então, para mim, isso realmente significou construir com base no conhecimento que eu tinha, mas também pensando sobre os locais reais onde a IA está sendo construída literalmente a partir de rochas, areia e óleo.

Que tipo de recepção o livro recebeu?

Uma das coisas que me surpreendeu nas primeiras respostas é que as pessoas realmente acham que esse tipo de perspectiva estava atrasado. Há um momento de reconhecimento de que precisamos ter um tipo de conversa diferente das que temos tido nos últimos anos.

Gastamos muito tempo nos concentrando em correções tecnológicas restritas para sistemas de IA e sempre centralizando tudo em respostas técnicas. Agora temos que lidar com a pegada ambiental dos sistemas. Temos que enfrentar as formas muito reais de exploração do trabalho que têm ocorrido na construção deles.

E agora também estamos começando a ver o legado tóxico do que acontece quando você simplesmente extrai o máximo de dados possível da Internet e chama isso de verdade. Esse tipo de enquadramento problemático do mundo produziu muitos danos e, como sempre, eles foram sentidos principalmente por comunidades que já estavam marginalizadas e não experimentavam os benefícios desses sistemas.

O que você espera que as pessoas comecem a fazer de maneira diferente?

Espero que seja muito mais difícil ter essas conversas que não levam a lugar algum em que termos como “ética” e “IA para o bem” foram completamente esvaziados de qualquer significado real. Espero que as cortinas se abram e possamos ver realmente quem está comandando as alavancas desses sistemas. Isso significa deixar de se concentrar apenas em coisas como princípios éticos e passar a falar sobre poder.

Como podemos nos afastar desse enquadramento ético?

Se houve uma verdadeira armadilha no setor de tecnologia na última década, é que a teoria da mudança sempre foi centrada na engenharia. Sempre foi: “Se houver um problema, há uma solução técnica para ele”. E apenas recentemente começamos a ver isso se ampliando para “Oh, bem, se houver um problema, então a regulamentação pode corrigi-lo. Os formuladores de políticas têm uma função”.

Mas acho que precisamos ampliar isso ainda mais. Temos que dizer também: onde estão os grupos da sociedade civil, onde estão os ativistas, onde estão os defensores que estão tratando de questões de justiça climática, direitos trabalhistas, proteção de dados? Como os incluímos nessas discussões? Como incluímos as comunidades afetadas?

Em outras palavras, como podemos tornar essa conversa democrática muito mais profunda em torno de como esses sistemas já estão influenciando a vida de bilhões de pessoas de maneiras basicamente irresponsáveis que vivem fora da regulamentação e da supervisão democrática?

Nesse sentido, este livro está tentando descentralizar a tecnologia e começar a fazer perguntas maiores em torno de: em que tipo de mundo queremos viver?

Em que tipo de mundo você quer viver? Com que futuro você sonha?

Eu quero ver os grupos que têm feito o trabalho realmente árduo de abordar questões como justiça climática e direitos trabalhistas se reunirem, e perceber que essas frentes antes bastante distintas de mudança social e justiça racial realmente compartilham preocupações e um terreno comum no qual eles podem coordenar e organizar.

Porque temos muito pouco tempo aqui. Estamos lidando com um planeta que já está sob forte pressão. Estamos olhando para uma profunda concentração de poder em, extraordinariamente, poucas mãos. Você realmente teria que voltar aos primeiros dias da indústria ferroviária para ver outro setor tão concentrado, e agora você poderia até dizer que a tecnologia superou isso.

Portanto, temos que lidar com diferentes maneiras de pluralizar nossas sociedades e ter maiores formas de responsabilidade democrática. E esse é um problema de ação coletiva. Não é um problema de escolha individual. Não é como se escolhêssemos a marca de tecnologia mais ética da prateleira. Trata-se de encontrar maneiras de trabalhar juntos nesses desafios em escala planetária.

Atualização: A descrição do AI Now Institute foi esclarecida.