Este foi um ano fora do comum para a Inteligência Artificial (IA). Se você passou muito tempo online, provavelmente já se deparou com imagens geradas por sistemas de IA como o DALL-E 2 ou o Stable Diffusion, ou piadas, artigos ou outros textos escritos pelo ChatGPT, a última versão do grande modelo de linguagem GPT-3 da OpenAI.

Às vezes é óbvio quando uma imagem ou um texto foi criado por uma IA. Mas, cada vez mais, o resultado gerado por esses modelos podem facilmente nos levar a pensar que foi produzido por um humano. E os grandes modelos de linguagem, em particular, são mentirosos confiantes: eles criam textos que parecem corretos, mas na verdade podem estar cheios de mentiras.

Embora isso pareça não ter importância se os textos e imagens gerados forem apenas um pouco engraçados, se os modelos de IA forem usados para oferecer conselhos de saúde sem filtro ou outras formas de informações importantes, essa habilidade pode ter sérias consequências. Os sistemas de IA também podem tornar estupidamente fácil distorcer as informações que consumimos e até mesmo nosso senso de realidade para produzir páginas e mais páginas de desinformação, conteúdos abusivos e spam. Pode ser particularmente preocupante em épocas de eleições, por exemplo.

A proliferação desses grandes modelos de linguagem facilmente acessíveis levanta uma questão importante: como saberemos se o que lemos online é escrito por um humano ou por uma máquina? Acabei de publicar um artigo analisando as atuais ferramentas que temos para detectar texto gerado por IA. Alerta de spoiler: nosso arsenal de ferramentas de detecção de hoje é totalmente ineficaz contra o ChatGPT.

Mas a longo prazo, isso tem uma implicação mais séria. Podemos estar presenciando, em tempo real, o nascimento de uma bola de neve de bobagens.

Grandes modelos de linguagem usam conjuntos de dados que são construídos a partir da busca de textos na Internet para treinamento, incluindo todas as coisas tóxicas, idiotas, falsas e maliciosas que os humanos escreveram. Os modelos de IA finalizados cospem essas falsidades como fatos, e sua produção é espalhada por toda parte da web. E então as empresas de tecnologia vasculham novamente a Internet, coletando textos escritos por IA que são usados para treinar modelos maiores e mais convincentes, que os humanos podem usar para gerar ainda mais bobagens antes de outra busca ser feita de novo e de novo, ad nauseam (até provocar enjôo, em português).

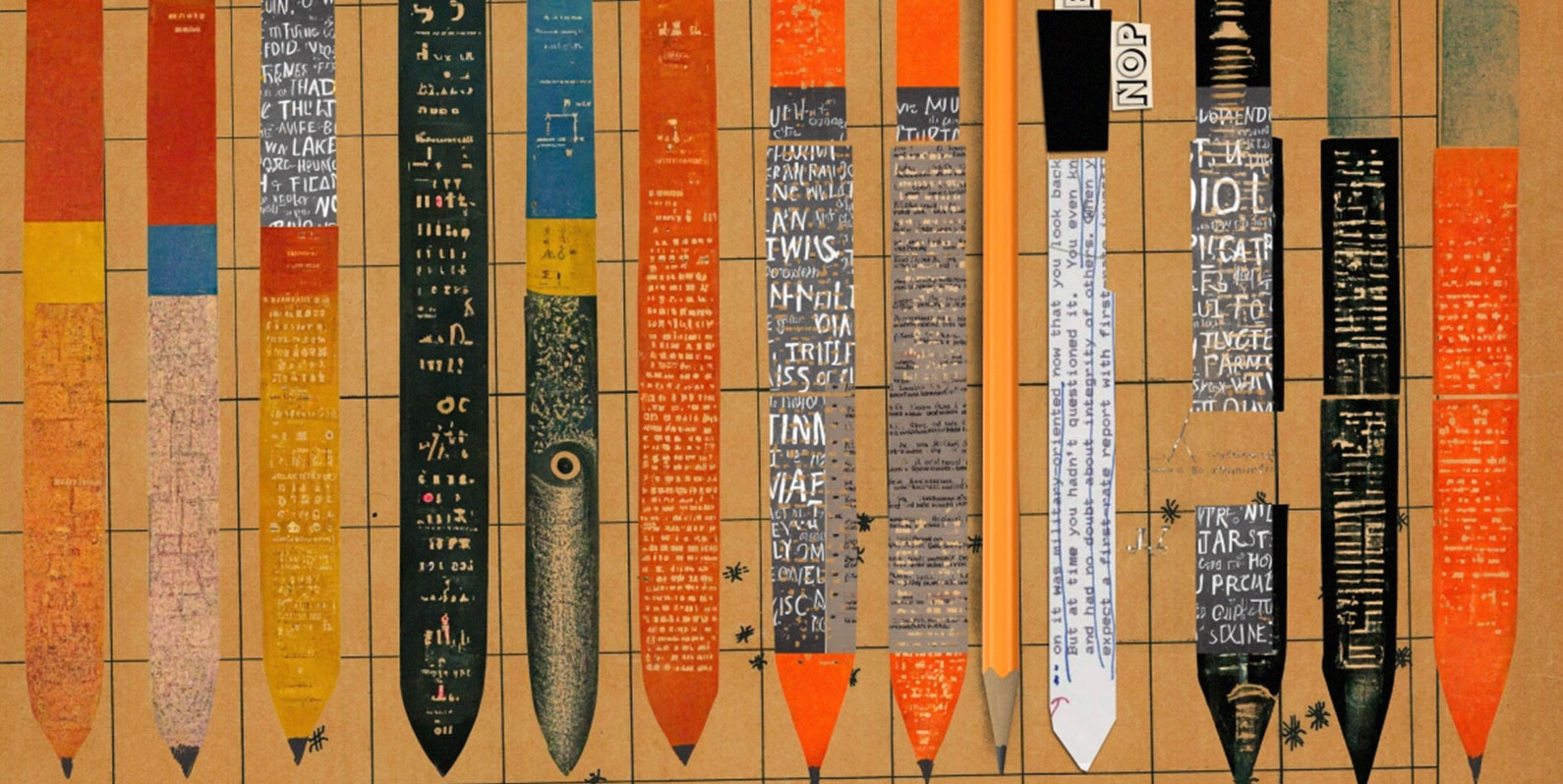

A IA se alimentar de si mesma e produzir resultados cada vez mais contaminados é um problema que se estende às imagens. “A internet agora está para sempre contaminada com imagens feitas por IA”, disse Mike Cook, um pesquisador de IA do King’s College London (Reino Unido), ao meu colega Will Douglas Heaven em seu novo artigo sobre o futuro dos modelos generativos de IA.

“As imagens produzidas em 2022 farão parte de qualquer modelo que for feito a partir de agora”.

No futuro, vai ficar cada vez mais complicado encontrar dados de treinamento de boa qualidade e livres de IA, diz Daphne Ippolito, pesquisadora sênior do Google Brain, a unidade de pesquisa de deep learning da empresa. Aspirar cegamente todos os textos que encontramos na Internet não será o ideal se quisermos impedir que futuros modelos de IA gerem materiais preconceituosos e com falsidades incorporados ao enésimo grau.

“É realmente importante considerar se precisamos treinar os modelos em todo e qualquer conteúdo que encontramos na Internet ou se há maneiras de filtrar apenas as coisas de maior qualidade e que resultarão no tipo de modelo de linguagem que queremos”, diz Ippolito.

Construir ferramentas para detectar texto gerado por IA se tornará crucial quando, inevitavelmente, as pessoas tentarem apresentar artigos científicos ou acadêmicos escritos por IA ou ainda usar IA para criar fake news ou desinformação.

Ferramentas técnicas podem ajudar, mas os humanos também precisam se tornar mais espertos no que diz respeito à IAs.

Ippolito diz que em textos gerados por IA você pode encontrar alguns sinais reveladores. Os seres humanos são escritores confusos. Nosso texto está cheio de erros de digitação e gírias, e procurar por esses tipos de erros e nuances sutis é uma boa maneira de identificar se o texto foi escrito por um ser humano. Por outro lado, grandes modelos de linguagem funcionam prevendo a próxima palavra em uma frase e são mais propensos a usar palavras comuns como “the”, “it” ou “is” em vez de palavras pouco usadas e confusas. E embora eles quase nunca errem as palavras, eles entendem as coisas errado. Ippolito diz que as pessoas devem procurar inconsistências sutis ou erros factuais em textos que são apresentados como fatos, por exemplo.

A boa notícia é: a pesquisa de Ippolito mostra que, com a prática, os humanos podem se treinar para identificar melhor o texto gerado pela IA. Talvez ainda haja esperança para todos nós.

Um aprendizado ainda mais profundo

Um robô aspirador Roomba gravou uma mulher no banheiro. Como as capturas de tela feitas por ele foram parar no Facebook?

Essa história me arrepiou toda. No início de 2022, minha colega Eileen Guo teve acesso a 15 capturas de tela de fotos privadas tiradas por um aspirador de pó, incluindo imagens de alguém sentado no vaso sanitário, postadas em grupos fechados em uma rede social.

Quem tirou as fotos? A iRobot, desenvolvedora do robô aspirador Roomba, diz que as imagens não vieram das casas de clientes, mas de “coletadores de dados e funcionários pagos” que assinaram acordos por escrito reconhecendo que estavam enviando transmissões de dados, incluindo vídeos, para a empresa para fins de treinamento. Mas não está claro se essas pessoas sabiam que haveriam humanos, em particular, vendo essas imagens para treinar a IA.

Por que isso é importante: a história ilustra a prática crescente de compartilhar dados potencialmente confidenciais para treinar algoritmos, bem como a surpreendente jornada global que uma única imagem pode ter. Neste caso, de residências na América do Norte, Europa e Ásia para os servidores da iRobot com sede em Massachusetts (EUA), de lá para a Scale AI com sede em São Francisco (EUA) e, finalmente, para os trabalhadores de dados contratados da Scale em todo o mundo. Juntas, as imagens revelam toda uma cadeia de fornecimento de dados que poucos consumidores conhecem, além de novos pontos onde informações pessoais podem vazar. Leia a história aqui.

Bits e bytes

O fundador da OpenAI, Sam Altman, nos conta o que aprendeu com o DALL-E 2

Altman conta a Will Douglas Heaven por que ele acha que DALLE-2 foi um sucesso tão grande, que lições ele aprendeu com seu sucesso e o que modelos como esse significam para a sociedade. (Tech Review americana)

Artistas agora podem optar por não participar da próxima versão do Stable Diffusion

A medida é resultado de um acalorado debate público entre artistas e empresas de tecnologia sobre como os modelos de IA de conversão \de texto em imagem são treinados. Desde o lançamento do Stable Diffusion, os artistas estão em pé de guerra, argumentando que o modelo os rouba ao incluir muitos de seus trabalhos protegidos por direitos autorais sem pagar nada a eles ou dar qualquer tipo de direito. (Tech Review americana)

A China baniu muitos tipos de deepfakes

A Administração Chinesa do Ciberespaço proibiu o uso de deepfakes criadas sem a permissão dos indivíduos e que vão contra os valores socialistas ou disseminam “informações ilegais e prejudiciais”. (The Register)

Como é ser o backup humano de um chatbot

Quando era uma estudante, a escritora Laura Preston teve um trabalho incomum: intervir quando um chatbot de IA imobiliário chamado Brenda saía do roteiro. O objetivo era que os clientes não notassem. O artigo mostra o quão burra a IA de hoje pode ser em situações da vida real e quanto trabalho humano é necessário para manter a ilusão de máquinas inteligentes. (The Guardian)